Проблема deepfakes: как ее решают блокчейн и ИИ

{"images":[{"id":3792}]}

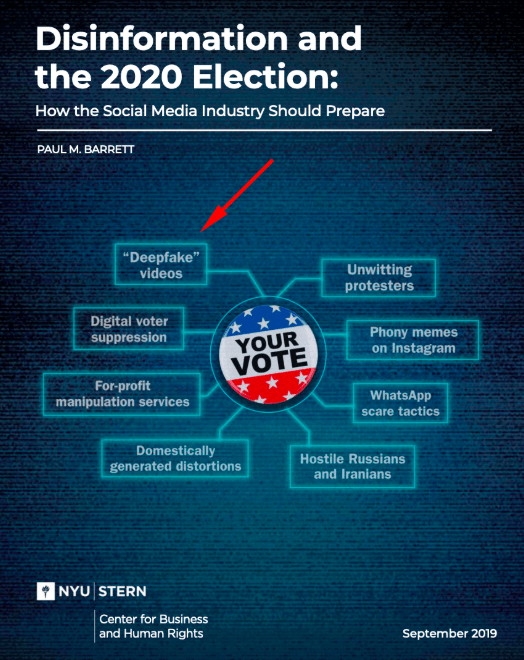

Эксперты бьют тревогу в свете растущей угрозы со стороны deepfakes — фейковых видео, на которых люди делают то, чего на самом деле не делали. Используя технологию машинного обучения, на персонажей ролика накладывают другие лица, которые выглядят так натурально, что их почти не отличить от настоящих. С помощью срежиссированных видео можно дискредитировать президента или, предположим, посадить в тюрьму жертву вместо недобросовестного полицейского. Так, аналитики Нью-Йоркского университета назвали deepfakes одной из главных угроз для надвигающихся президентских выборов в США. Кто или что сможет решить эту проблему? Правильно — блокчейн-технология в дуэте с Искусственным Интеллектом (ИИ).

Deepfakes = проблема

С каждым годом технологии становятся все изощреннее. Увы, совершенствуются не только полезные инновации, но и орудия мошенников. Еще 10 лет назад видеомонтаж распознавался очень легко — углядеть подделку мог любой человек, способный отличить круг от квадрата.

Однако с тех пор ситуация радикально изменилась. Вместо «волшебных» комбинаций «Ctrl + C, Ctrl + V» мошенники используют генеративно-состязательные нейросети (GAN) на базе ИИ. Этот инструмент делает видеомонтаж настолько реалистичным, что порой отличить муляж от подлинника практически невозможно. Полученные в результате такой обработки фейковые видео называются deepfakes и активно распространяются по всему интернету.

Все работает до неприличия просто:

ИИ использует алгоритм, одна часть которого анализирует фотографии и видео определенного человека.

Затем вторая часть алгоритма накладывает образ жертвы на любое видео, совершенствуя результат до тех пор, пока первая часть алгоритма не начнет путать копию с оригиналом.

Теоретически ваш сосед может создать любое фейковое видео с вашим участием, например, где вы просите милостыню. Впервые такие возможности были представлены в 2016 году группой исследователей Мюнхенского технического университета в области визуальных вычислений. С тех пор технология лишь набирает популярность.

Deepfake-технология применяется для создания порно со знаменитостями. Впрочем, легально наслаждаться видео с «Анджелинами Джоли» и «Сальмами Хайек» пришлось недолго. Многие площадки, включая Reddit и Pornhub, при модерации контента начали банить такие «шедевры».

На сером рынке сложнее что-то запретить, поэтому там вовсю гуляет реклама всяких фейков. Например, на просторах сети можно встретить рекламу «нового МММ» во главе с «куклой» покойного Сергея Мавроди, который по их легенде якобы не умер, а пережил инсульт.

Но далеко не все видео делаются во вред. Например, deepfake-технологию в мае использовали на выставке «Дали Жив» в честь 115-летия великого художника. В результате фейковый Дали выступил в музее перед своими поклонниками.

Однако все же большинство авторов deepfakes — рядовые граждане, создающие видео ради забавы или для демонстрации стремительного развития технологии. Невероятно убедительно видео, на котором актер Том Хейдер превращается в Тома Круза и обратно, при этом он абсолютно естественен в обоих образах.

А теперь представьте, что могут сделать с помощью такого инструмента профессиональные манипуляторы. В сети, помимо безобидных видео, легко встретить фейковые высказывания знаменитостей и политических деятелей.

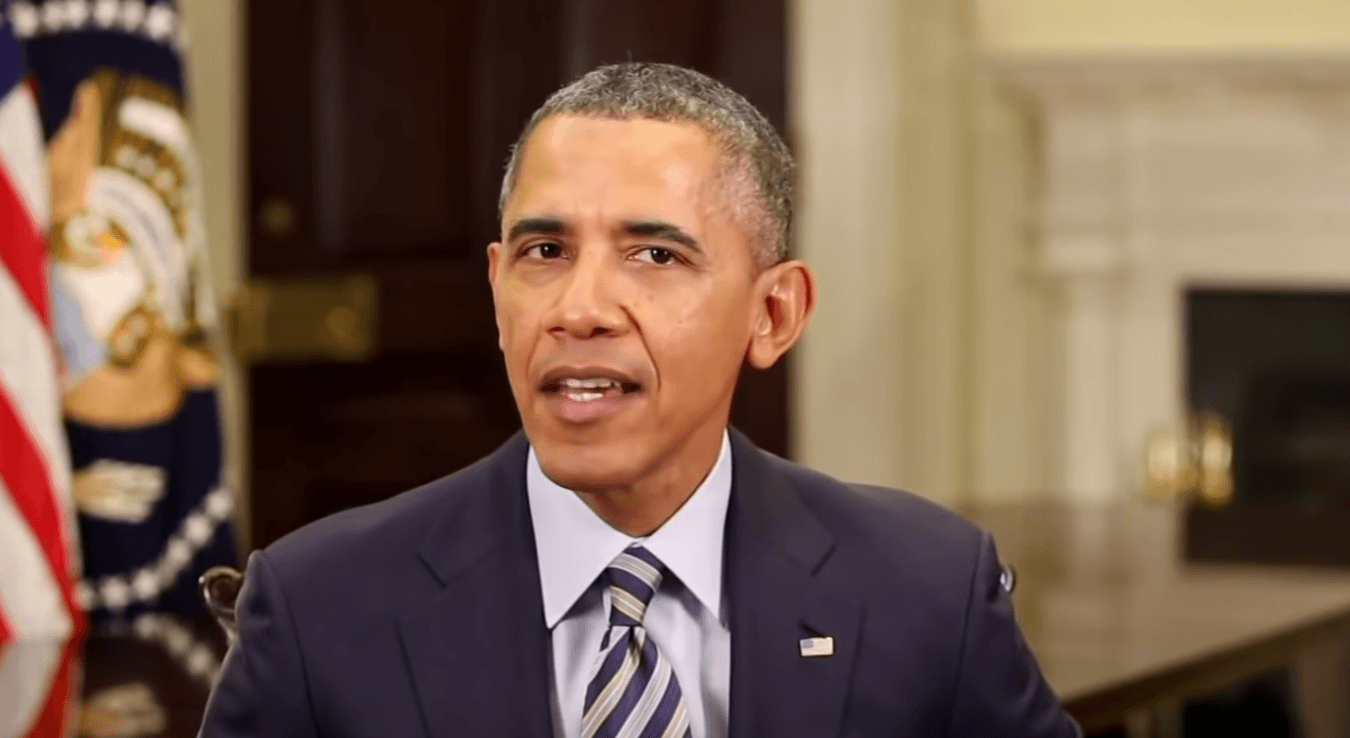

Чтобы показать угрозу наглядно, исследователи Университета Вашингтона создали модель экс-президента США Барака Обамы. На видео аналитиков смонтированный Обама ни в чем не уступает настоящему.

Одна из главных политических угроз 2020

Пятый пункт списка выше — главная проблема, ведь с помощью deepfakes можно дискредитировать кого угодно. Просматривая срежиссированный видеоролик, часть аудитории поймет, что это фейк, но всегда найдется и другая часть, которая поверит в сказанное и начнет распространять «новости» среди друзей.

Постоянное усовершенствование технологий усугубляет ситуацию.

Еще год назад смонтированные персонажи не умели моргать, а сегодня для них это не проблема.

Более того, ИИ позволяет имитировать не только лицо, но и движения тела или отдельных частей лица, например, губ.

Вдобавок не составляет труда подделать и голос.

Видео, на котором смонтированы только губы и голос, гораздо труднее идентифицировать как фейковое. Профессионалам несложно добавить в речь человека фразы, которые он не говорил, а то и вовсе сделать совершенно ложное заявление. Самое страшное, что это будет выглядеть убедительно.

Распознать профессионально сделанный монтаж сложно уже сейчас, а в дальнейшем будет еще сложнее. Согласно последнему исследованию Нью-Йоркского университета, deepfake-видео — одна из наиболее актуальных проблем, способных оказать значимое влияние на итоги президентских выборов США в 2020 году. По мнению аналитиков, срежиссированные видеоролики могут подорвать доверие к кандидатам и усугубить цинизм избирателей. 2 октября сенаторы США подтвердили угрозу deepfakes и призвали мировые компании сформировать стратегии для аутентификации видео.

Блокчейн = решение

Доступ к подобным видеоредакторам есть у всех желающих. Кто угодно, например, преступник или недобросовестный полицейский, могут создать deepfake-видео, в том числе подделать видеозаписи на нагрудных полицейских камерах. И дела обстоят гораздо серьезнее, чем может показаться на первый взгляд.

Видеозаписи с полицейских нагрудных камер используются как решающие доказательства в криминальных и политических ситуациях. Поэтому любые, даже теоретические нестыковки на таком уровне попросту недопустимы. Увы, но они уже есть: американские адвокаты и представители союза защиты гражданских свобод неоднократно подвергали сомнению полицейские видеоролики, отмечая добавление временных меток и сокращение времени сцен.

Axon — американская компания с благородным слоганом «Защита Жизни» выпускает полицейское оборудование в более чем 100 странах, в том числе нагрудные камеры. Недавно ведущий производитель обновил линейку устройств, выпустив новую камеру Axon Body 3. Помимо прочих улучшений она получила возможность защищать ролики шифрованием и паролем, а заодно прикреплять к записям цифровую подпись, чтобы отслеживать происхождение видео. Обновления безопасности призваны препятствовать созданию deepfakes и способствовать их разоблачению. На новых устройствах невозможно без аутентификации воспроизвести, скачать или редактировать видео.

«Угрозы deepfakes достаточно, чтобы вызвать общее недоверие к любым видео, в том числе и к видео на полицейских нагрудных камерах», — заявил представитель Axon.

Однако из-за централизации все эти меры все равно не гарантируют полной защиты, поэтому специалисты Axon намерены идти дальше. Компания изучает возможности интеграции в свои камеры блокчейн-технологии, чтобы информация о манипуляциях записывалась в публичный распределенный реестр и не могла быть изменена. А вот это уже действительно послужит гарантией защиты от тайного редактирования полицейских видеороликов. Таким образом, на данный момент полноценно защитить индустрию от одной из главных политических угроз будущего может только блокчейн-технология.

Такого же мнения придерживается и Шамир Аллибхай, СЕО стартапа Amber, который использует блокчейн-технологию для проверки подлинности видеоклипов на смартфонах. Он заявил, что нужно разработать открытые стандарты, чтобы проверить достоверность любых видеозаписей мог кто угодно и когда угодно.

Блокчейн и ИИ

Вероятнее всего, помогать блокчейн-технологии в этой миссии будет ИИ. Именно он будет проверять видео на подлинность, опираясь на данные распределенного реестра. В 2019 году этот дуэт уже активно используется различными компаниями.

ИИ великолепно справляется со сбором, анализом, сортировкой и передачей данных, улучшая скорость и качество исполнения внутренних процессов.

Блокчейн в свою очередь «следит», чтобы в работу ИИ никто не вмешивался — защищает данные и их последовательность от любых посягательств.

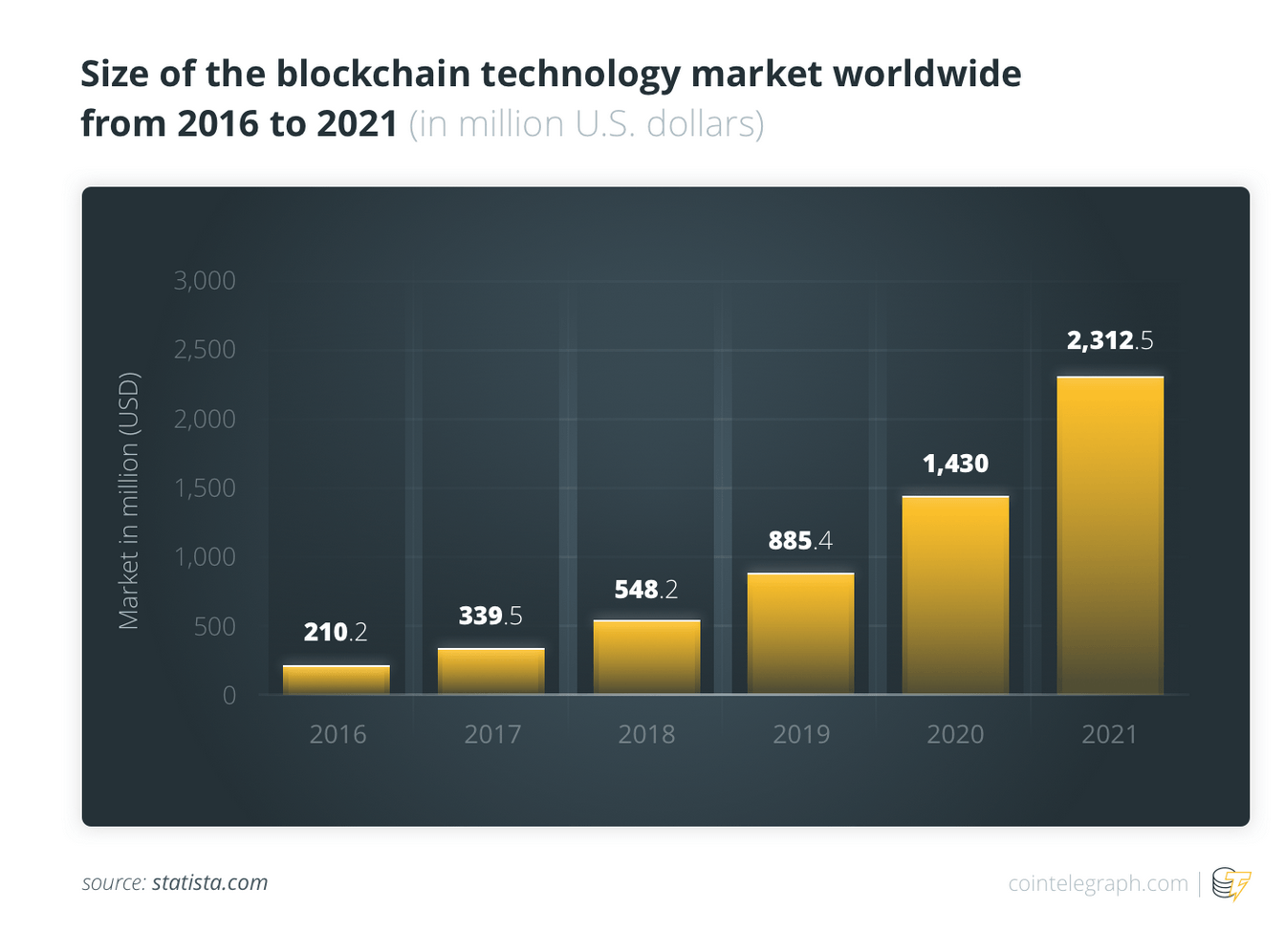

Axon — далеко не единственная организация, изучающая возможности внедрения блокчейн-технологии. Количество таких компаний с каждым годом растет. По данным Statista, в 2016 их капитализация насчитывала $210 млн, к 2019 она выросла более чем в 4 раза — до $885 млн. Более того, к 2021 ожидается рост до $2.3 млрд.

Современные стандарты движутся к тому, что в сфере управления данными ИИ без блокчейна будет никому не нужен. Блокчейн критически важен. «Мы не рассматриваем ИИ и блокчейн как две отдельные несовместимые технологии, а, скорее, как две технологии, которые могут очень хорошо дополнять друг друга», — заявил Пол Ли, соучредитель и генеральный директор Mind AI.

Власти в свою очередь идут навстречу молодым стартапам. Так, Евросоюз расширяет доступ к высококачественным данным для проектов на основе блокчейн-технологии и ИИ. Например, компании получают доступ к различной статистике, данным о правах собственности, информации о погоде и транспорте.

Когда ждать глобальную победу блокчейна и ИИ над deepfakes?

Популярность deepfakes растет, а программы для их создания лежат в открытом доступе. Пользователи прикидываются Ким Чем Ыном, накладывают лицо Джессики Альбы на актрис порно-кастингов, заменяют внешность президента Аргентины Маурисио Макри на Адольфа Гитлера. С помощью таких программ можно создать множество провокаций, не только абсурдных, а более тонких — таких, в которые легко поверить.

Не сомневаемся, что со временем deepfakes выйдут на уровень, когда отличить оригинал от копии без специальных инструментов будет попросту невозможно. Может, фейки будут даже более убедительными (вспомните, как Чарли Чаплин занял на конкурсе двойников только 3 место).

И не факт, что даже если к делу привлекут специально обученных экспертов, они однажды не допустят ошибку. Человеческий фактор никто не отменял. Гарантировать защиту от deepfakes реально только на техническом уровне — с исключением любых ошибок. Союз блокчейн-технологии и ИИ — решение этой проблемы. Создание программ на основе ИИ и блокчейна, а также интеграция технологий не только в полицейские нагрудные камеры, но и в камеры видеонаблюдения, устройства журналистов и смартфоны, сильно повлияли бы на ситуацию. Оригинальные видео могли бы содержать водяные знаки, подтверждающие их правдивость, а сервисы типа YouTube могли бы их распознавать. Смотря очередной ролик, мы бы видели пометку, что он подлинный. Это позволило бы гарантировать достоверность многих видеозаписей и навсегда решить проблему deepfakes.

Помогать бороться с обилием фейковых видео будут гиганты рынка. Facebook инвестировал $10 млн на создание организации «Deepfake Detection Challenge», Twitter удаляет фейковый контент и ищет пути для более качественного отслеживания, а Google собрала огромный сборник deepfake-видео для анализа.